Zu diesem Thema werde ich immer häufiger als Keynote Speaker angefragt. Das hat verschiedene Gründe – ich hoffe, dass mein Vorname* keiner davon ist. Es hat eher etwas damit zu tun, dass ich 1. Zukunftsforscher und 2. Hobby-IT-Nerd bin. 3. werden nur wenige technologische Entwicklungen unserer Zeit gleichzeitig derart über- und unterschätzt.

Eine derart globalgalaktische Fragestellung lässt sich in einem kurzen Blogbeitrag nur unbefriedigend beantworten. Aber ich möchte Ihnen gern ein Gefühl dafür geben und mir gleichzeitig Mühe, mich kurz zu fassen und trotzdem nicht zu viel auszuklammern.

Inhalt

ToggleWas ist Künstliche Intelligenz (KI)?

Bevor wissenschaftlich geprägte Menschen sich einer Fragestellung nähern, klären wir immer erst die grundlegenden Definitionen. Bereits 1955 prägte der US-amerikanische Informatiker und Autor John McCarthy bei der „Dartmouth Conference“ den Begriff „Künstliche Intelligenz“. Theoretisch wurde natürlich bereits vorher über die potenziellen Denkfähigkeiten von Maschinen spekuliert, an der Stelle ist in erster Linie Alan Turing zu nennen. Dieser entwickelte auch den Turing-Test, welcher feststellen soll, ob eine Maschine in der Kommunikation noch von einem Menschen zu unterscheiden ist oder nicht. Der Turing-Award wiederum wird seit 1966 jährlich verliehen und ist so etwas wie der Nobelpreis für Informatiker:innen.

Künstliche Intelligenz ist dem Gehirn nachempfunden

Seit fast 70 Jahren steht nun also der Begriff Künstliche Intelligenz im Raum, doch praktisch hat die Entwicklung erst seit der Jahrtausendwende Fahrt aufgenommen. Das hat viel mit dem Geschwindigkeitsanstieg von Computerchips zu tun (s. Moore’sches Gesetz). Denn die Grundlage für KI ist natürlich genau das: sehr schnelle Rechenmaschinen, die in kurzer Zeit viele Daten verarbeiten können. Der Grundgedanke dahinter ist die Annahme, dass unser Gehirn letztlich auch nichts anderes tut als sehr viele Reize (= Daten), die permanent auf uns einprasseln, schnell zu verarbeiten. Wir nutzen dafür die Macht der Neuronen und Synapsen zwischen unseren Ohren; ein Computer nutzt dafür seinen Prozessor (CPU oder GPU) und die Festplatte (oder andere Speichereinheiten).

In unserem Hirn feuern die Synapsen in atemberaubender Geschwindigkeit, wenn bspw. ein optischer Reiz vom Auge ans Gehirn gesendet wird. Diverse Prozesse des Gehirns prüfen zunächst, ob der Reiz eine Bedrohung darstellt, ordnet den Reiz sodann in bekannte Muster ein und aktiviert die Datenverarbeitung – beispielsweise, um eine Handlung auszuführen oder erst einmal ausgiebig darüber nachzudenken. Jeder Mensch hat dafür seine eigenen Muster und Vorurteile, was auch einen Teil meines Slogans „Zukunft ist eine Frage der Perspektive“ begründet. Für die Thematik der Künstlichen Intelligenz ist für uns aber wichtiger, dass diese Datenverarbeitung unseres Gehirns schrittweise von der Informatik (und Kybernetik) imitiert wird, um automatisierte Denkmaschinen herzustellen. Manche sprechen bereits von Leben 3.0 (vor allem der MIT-Professor Max Tegmark), also einer synthetischen Form des Lebens, die sich ihrer selbst bewusst werden und nach eigener Agenda handeln könnte.

Definition Künstliche Intelligenz (EU)

Es ist nicht leicht, eine geeignete Definition Künstlicher Intelligenz zu finden. Ich habe mich für die Variante der High-Level Expert Group on Artificial Intelligence der Europäischen Kommission entschieden:

„Künstliche-Intelligenz-(KI)-Systeme sind vom Menschen entwickelte Software- (und möglicherweise auch Hardware-) Systeme, die in Bezug auf ein komplexes Ziel auf physischer oder digitaler Ebene agieren, indem sie ihre Umgebung durch Datenerfassung wahrnehmen, die gesammelten strukturierten oder unstrukturierten Daten interpretieren, Schlussfolgerungen daraus ziehen oder die aus diesen Daten abgeleiteten Informationen verarbeiten und über die geeignete(n) Maßnahme(n) zur Erreichung des vorgegebenen Ziels entscheiden. KI-Systeme können entweder symbolische Regeln verwenden oder ein numerisches Modell erlernen, und sind auch in der Lage, die Auswirkungen ihrer früheren Handlungen auf die Umgebung zu analysieren und ihr Verhalten entsprechend anzupassen.“

zitiert nach: Europäische Kommission (2020): Weißbuch: Zur Künstlichen Intelligenz – ein europäisches Konzept für Exzellenz und Vertrauen, S. 19. Online: https://ec.europa.eu/info/publications/white-paper-artificial-intelligence-european-approach-excellence-and-trust_en (Abruf am 20.01.2021)

Kurz: KI-Anwendungen sind technische Einrichtungen, die computergestützt Daten verarbeiten und autonom Entscheidungen treffen.

Kurz und laiengerecht: KI ist nicht, wenn eine Maschine etwas kann, was bisher nur Menschen konnten. KI ist, wenn eine Maschine etwas kann, aber niemand genau versteht, warum.

Was ist Künstliche Intelligenz nicht?

Intelligent.

Vieles im Feld der künstlichen Intelligenz wirkt geradezu magisch, wenn man die Grundlagen nicht durchdrungen hat. Das ist auch nicht schlimm, dafür haben Sie ja mich. Maschinen vollbringen zwar bereits Wunder, doch hat das wenig mit der „Intelligenz“ der Maschine zu tun.

Schwache Künstliche Intelligenz

Die wichtigsten Felder der Künstlichen Intelligenz tummeln sich unter dem Begriff des Maschinellen Lernens (inkl. Maschine Learning, Deep Learning, Artificial Neural Networks). Das Prinzip des Maschinellen Lernens (ML) orientiert sich zwar an Lernvorgängen biologischer Wesen, doch wird in der Regel sehr klar vorgegeben, was die Maschine erledigen und wie sie lernen soll (hier unterscheidet man noch das überwachte und unüberwachte Lernen). Dabei geht es bislang immer um sehr spezifische Problemstellungen, die von der Maschine gelöst werden sollen. Es ist also eine schwache Intelligenz (engl. narrow artificial intelligence).

Starke Künstliche Intelligenz

Das Ziel der Entwicklung, gewissermaßen der „heilige Gral“ der KI-Forschung, ist zwar die allgemeine KI (engl. artificial general intelligence). Doch davon sind wir noch viele Jahrzehnte bis Jahrhunderte entfernt; manche nehmen sogar an, dass dieser Schritt unmöglich ist. Dazu müsste nämlich die Maschine ein Bewusstsein entwickeln – und wir müssten das auch erkennen. Der aktuelle Pfad zeigt in eine vollkommen andere Richtung: Menschen entwickeln begrenzt intelligente Maschinen, um die Probleme der Menschen und der Umwelt zu lösen. Ich habe weniger Angst vor einer bösartigen Künstlichen Intelligenz nach dem Terminator-Vorbild als vor einem irren Diktator, der perfekt trainierte Killermaschinen in den Krieg sendet. Daher befürworte ich auch ein Moratorium von KI-Systemen in bestimmten Bereichen, darunter auch Kriegsführung.

Schauen wir uns ein paar wichtige Meilensteine der Künstlichen Intelligenz an, um zu verstehen, wo wir stehen.

Status Quo (ausgewählte Use Cases)

Seit gut zehn Jahren überschlagen sich die Meldungen über Durchbrüche in der KI-Entwicklung. Ich habe ein paar Schlaglichter für Sie ausgewählt, mit denen Sie mindestens im Freundeskreis, vielleicht sogar in der Geschäftsführung punkten können:

2011: IBM Watson gewinnt bei Jeopardy

Der von IBM entwickelte Supercomputer Watson wurde 2011 auf die zwei besten menschlichen Kandidaten in der Quizshow Jeopardy losgelassen. Die Show funktioniert so, dass die Moderation eine Antwort nennt und die Kandidat:innen die gesuchte Frage finden müssen. Watson wurde darauf trainiert, alle vorigen Sendungen mit einer Lexikon-Datenbank zu verknüpfen sowie natürliche Sprache zu verstehen. Darüber hinaus wurde er mit einer begrenzten Risikobereitschaft ausgestattet, denn bei derart offenen Fragestellungen kann man nicht immer auf die hundertprozentige Gewissheit warten, bis man den Buzzer drückt. Sie ahnen bereits, wer als Sieger aus dem Spiel ging: Watson. Schauen Sie selbst:

Das ist nett, doch für die echte Welt noch wenig hilfreich. Das hat sich schon bald geändert, als Watson bereits 2013 für den Einsatz in der Onkologie weiterentwickelt wurde. Seither gilt Watson als bester Krebsdiagnostiker der Welt dank seiner übermenschlichen Fähigkeit, beliebig viele Daten zu kombinieren und bspw. MRT-Bilder von Patienten mit der Datenbank bekannter Krebsarten zu korrelieren. Das Ergebnis seiner Berechnung erscheint nach wenigen Sekunden auf dem Tablet des behandelnden Arztes, der sehr viel schneller und effizienter eine Aussage treffen und ggf. eine Therapie wählen kann:

2011: Sprachassistenten auf dem Vormarsch

Sprechen Sie gelegentlich mit Siri, Alexa, Hey Google, Cortana oder Bixby? Das sind die beliebtesten Sprachassistenten, die inzwischen von ungefähr drei Vierteln der in Deutschland lebenden Menschen genutzt werden – sogar beim Banking. Die Grundlage ist das sogenannte Natural Language Processing (NLP), also die Verarbeitung natürlicher Sprache. Da wenige Menschen eine komplett korrekte Aussprache haben, mussten die Assistenten lernen, Dialekte zu erkennen, Betonungen zu gewichten und all das, was unser Ohr und Gehirn sonst für uns übernimmt zu lernen. 2011 kam Siri auf den Markt und war noch vergleichsweise dumm, konnte nur eine kleine Bandbreite vorgefertigter Sprachbefehle verarbeiten – und das nur dann, wenn der Mensch sehr deutlich gesprochen hat. Das hat sich seither geändert, weil inzwischen Milliarden bis Billionen Aufnahmen verarbeitet und analysiert wurden, um daraus neue Muster zu erkennen. Daraus entsteht für die Nutzer:innen ein klarer Vorteil, nicht zuletzt für wenig technikaffine Menschen sind Sprachassistenten ein einfacher Zugang zu Technologie, bspw. um im Smart Home Licht, Musik oder Temperatur sowie im modernen Fahrzeug das Navigationssystem freihändig zu steuern.

Andere Anwendungen kombinieren die Sprach- mit der Stimmanalyse, um Marker in der Stimme zu analysieren und wahlweise den emotionalen Zustand (engl. affective AI), psychologische Grundbedingungen oder schwere Erkrankungen darin zu erkennen.

2016: AlphaGo bezwingt den besten Go-Spieler

Als ein Schachcomputer 1997 gegen den damaligen Weltmeister Garry Kasparov gewann, staunte die Welt. Das hatte nur bedingt etwas mit KI zu tun, weil Schach zwar einerseits als Spiel der Könige ein gewisses Strategieverständnis voraussetzt, letztlich aber vor allem Erfahrung und Vorausdenken kommender Kombinationen und Zwänge des Gegners erfordert. Das war relativ leicht programmiert. Anders sieht es beim chinesischen Brettspiel Go aus, in dem es ungleich mehr Kombinationen gibt (mehr als Atome im Universum). Man kann einer Maschine nach heutigem Stand nicht alle möglichen Kombinationen beibringen, weil das Brett größer und die Funktionen der Figuren weniger determiniert sind. Deshalb dachten selbst führende KI-Expert:innen bis 2016 auch, dass es noch mehrere Jahre oder Jahrzehnte dauern würde, bis ein Computer gegen einen menschlichen Go-Spieler gewinnen könnte. Sie lagen falsch.

In einem atemberaubenden Duell trat der damals beste Spieler Lee Sedol gegen AlphaGo an, welches von Alphabet (Googles Mutterkonzern) entwickelt wurde. Der Computer gewann deutlich mit 4:1 und verblüffte vor allem durch seine Kreativität; einige Spielzüge konnte die Fachwelt und die Kommentatoren einfach nicht einordnen. Sie erschienen zunächst irrational, haben sich aber viele Runden später als raffinierte taktische Manöver entpuppt. Inzwischen gibt’s sogar eine Dokumentation zu AlphaGo:

Auch hier stellt sich wieder die Frage, wo der Sinn in einer Maschine liegt, die Menschen in ihren eigenen Spielen schlagen. Ganz einfach; AlphaGo wurde bald zu AlphaFold und begann, die grundlegenden Muster der Biologie zu erforschen. Die KI bzw. das maschinelle Lernen von AlphaFold erreichte Ende 2020 den Durchbruch und sagte die Proteinstruktur basierend auf der Aminosäuresequenz des Proteins voraus; eine 50-Jahre alte Herausforderung der Biologie. Wozu nützt das? Viele Krankheiten sind direkt mit Proteinfunktionen verknüpft, darunter Krebs und Demenz. Das bedeutet, nun können Forscher:innen besser Krankheiten verstehen und hoffentlich bald wirksame, potenziell auch individualisierte Gegenmittel dazu entwickeln:

Ein ähnliches Verfahren wurde übrigens von Pharmazieunternehmen angewandt, um Gegenmittel für Covid-19 zu entwickeln. Bedeutet in kurz: Künstliche Intelligenz beschleunigt die Forschung und Entwicklung in der Medizin und Pharmakologie enorm.

2019: Bildmanipulation in (bald) Echtzeit mit StarGAN v2

In Zeiten von Fehlinformationskampagnen und Fake News fehlte gerade noch eine Software, die beliebige Bilder manipulieren kann. Donald Trump zeigt den Hitlergruß? Kein Problem, StarGAN kann das. Hitler umarmt Barack Obama? Auch das dürfte kein Problem sein, doch spätestens hier würden historisch Gebildete den Fehler bemerken. Das ist leider nicht immer so, da die Fälschungen immer besser werden. Mitschuld daran trägt die Technologie „StarGAN“ (das GAN steht für „Generative Adversarial Networks“). 2019 haben Forscher:innen das erste Mal diese Netzwerke antrainiert und vorgeführt, die Weiterentwicklung wurde bereits wenige Monate später unter Open Access veröffentlicht. Sehen Sie hier, was die KI kann:

In wenigen Jahren erwarte ich daher Film- und Serienproduktionen, die komplett ohne Set und Schauspieler:innen produziert wurden – und dennoch mit realistischen Figuren bestückt sind. Und wer weiß, vielleicht werde ich auch meine Vorträge mit StarGAN automatisieren?!

2020: Textautomatisierung mit GPT3

Schließlich ein wichtiger Durchbruch auf dem Gebiet der automatisierten Texterstellung. Das Kürzel GPT3 steht für „Generative Pre-trained Transformer 3“ und ist die Weiterentwicklung eines von OpenAI initiierten Projekts, um Texte von KIs schreiben zu lassen. Die beiden Vorläufer waren schon erstaunlich, doch GPT3 toppt alles vorher Dagewesene. Die britische Tageszeitung „The Guardian“ hat einen kompletten Artikel aus der „Feder“ von GPT3 veröffentlicht:

https://www.theguardian.com/commentisfree/2020/sep/08/robot-wrote-this-article-gpt-3

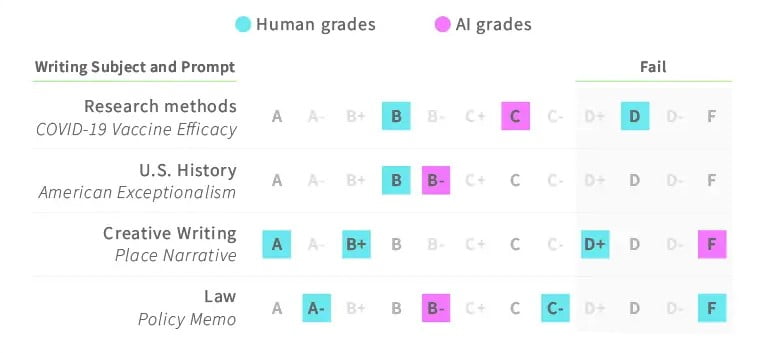

Kurz darauf traten Studierende gegen GPT3 in einen Wettbewerb um das bessere Essay – raten Sie, wer gewann: https://mixed.de/openai-gpt-3-vs-studis-wer-kriegt-die-besseren-noten/

… genau, die KI. Professor:innen haben den Unterschied nach kleineren Anpassungen nicht festgestellt:

Lustige Anwendungen

KI-Anwendungen werden auch oft noch eher experimentell und vor allem von einer großen Community von IT-Geeks entwickelt. Diese Seite listet kostenlose, meist unterhaltsame Anwendungen auf – darunter ein Kunstsimulator, eine Songtexte-KI oder KI-colorierte Filmklassiker: https://boredhumans.com/

Business-Anwendungen

In meinen Vorträgen zeige ich auch je nach Kontext aktuelle Anwendungen aus den Bereichen Justiz, Personalwesen, Mobilität (v.a. autonomes Fahren), Bildung, Handwerk, Medizin, Maschinenbau (und viele mehr) und was eben gerade passt. Das würde hier aber den Rahmen sprengen. Ich würde behaupten, dass es keine größere Branche gibt, in der es nicht bereits Anwendungen gibt, die Prozesse mithilfe von KI automatisieren oder autonomisieren. Gleichzeitig arbeiten KI-Forscher:innen weltweit daran, KI-Anwendungen erklärbar zu machen – subsumiert unter dem Stichwort explainable / intelligible AI (erklärbare oder sich selbst erklärende KI).

Nehmen Sie gern Kontakt auf, wenn Sie eine individualisierte Zusammenstellung in Keynote-Form interessiert.

Ausblick 2050: Transmodern Liberty

Was kommt danach?

Klassischerweise schauen Zukunftsforscher:innen eher 5-10 Jahre in die Zukunft. Aber dazu erscheint dieses Jahr noch ein Buch, dessen Mitherausgeber ich bin („Arbeitswelt und Künstliche Intelligenz 2030“). Daher möchte ich hier den Blickwinkel auf die fernere Zukunft richten: 2050.

Die Schnittstelle von KI-Anwendungen ist: Bei dieser Welle der Industrialisierung geht es nicht (nur) darum, physische Körperkraft auf Maschinen zu übertragen, sondern auch kognitive Fähigkeiten. Daher sind auch hochqualifizierte Akademiker:innen nicht sicher vor Automatisierungstendenzen. Die Auswirkungen davon können sehr vielseitig sein und werden je nach Wirtschafts- und Gesellschaftskontext in den nächsten Jahrzehnten sehr unterschiedlich bewertet werden. In den meisten industrialisierten Volkswirtschaften ist ein (bedingungsloses) Grundeinkommen sehr wahrscheinlich – nicht zuletzt, da es von der aktuellen Wirtschaftselite sogar vorangetrieben wird. Wer zahlt die Steuern? Na, die Roboter und Algorithmen!

Mein Zukunftsbild im technologischen Bereich nennt sich „Transmodern Liberty“. Der Begriff setzt sich aus den Elementen einer Transmodernen Gesellschaft sowie einer neuen Qualität des Freiheitsbegriffs zusammen und ist eine optimistische Variante der Zukunft. Mein Szenario beinhaltet unter anderem folgende Aspekte:

Technologie macht Menschen menschlich

Was widersprüchlich klingt, ist mein voller Ernst. Der richtige Einsatz der Technologie, allen voran Künstliche Intelligenz, könnte im besten Fall dazu führen, dass erstmals in der Geschichte der Menschheit alle Menschen menschlich sein dürfen. Was heißt menschlich? Für mich heißt das, sich nicht tagtäglich um die Versorgung existenzieller Bedürfnisse kümmern zu müssen. Dieses Privileg war seit Beginn der Menschheit (wenn überhaupt) einer kleinen Elite vorbehalten. Doch wenn die Grundbedürfnisse durch automatisierte Prozesse gedeckt werden können, entsteht zumindest die Möglichkeit, dass Erwerbsarbeit obsolet wird – stattdessen gehen Menschen „arbeiten“, weil es ihren individuellen Stärken und Interessen entspricht und sie dadurch einen Beitrag zur Gesellschaft leisten.

Sapiens 2.0 wird geboren

Oft spreche ich in meinen Vorträgen über den Homo Prospectus als zukunftsdenkenden Menschen. Das ist ein Bestandteil einer neuen Form der Menschlichkeit; damit sind nicht genetisch optimierte Menschen gemeint, sondern diejenigen mit einem kosmopolitischen Mindset und dem Verständnis der Transmodern Liberty. Sie basieren auf einer aktualisierten Fassung der Aufklärung und des Humanismus, erkennen jegliches Leben als gleichwertig an und sind ohne äußere Zwänge frei in der Entfaltung der eigenen Biographien.

Automatisierung der Diplomatie und Global Governance

Neben der Produktion alltäglicher Güter und der Infrastruktur muss natürlich auch die Staatsführung automatisiert werden. Wem nützt es, wenn innerhalb einiger geschlossener Nationalstaaten die Wirtschaft automatisiert wird, der Nachbarstaat aber regelmäßig diplomatische Krisen verursacht oder Spitzenbeamten und -politiker:innen korrupt sind? Eben. Hier erkennen wir zunehmend den Trend zu einer echten Tianxia, also einem global inklusiven Politiksystem: Es erkennt einerseits die kulturellen und historischen Verschiedenheiten der Menschen und Territorien an, nivelliert andererseits aber menschliche Abgründe wie Gier, Hass oder Rache durch kluge Diplomatie. Wenn ein Computer im Go gegen einen Menschen gewinnt, wird er jawohl auch bald eine diplomatische Krise moderieren können. Fragen Sie mal die Menschen in Krisen- und Kriegsgebieten, die haben schon heute keine Lust auf Terror.

Zurück in die Gegenwart

Künstliche Intelligenz wird die Welt mindestens genauso stark verändern wie Strom oder die Bändigung des Feuers. Das sage nicht ich, sondern Google CEO Sundar Pichai 2018, doch ich stimme ihm zu. Gleichzeitig setze ich mich dafür ein, mehr Aufklärung zu schaffen und das Thema zu entmystifizieren. Die Erwartungen für das laufende Jahrzehnt reichen von der Angst vor einem Terminator-Szenario oder Komplettautomatisierung bis zu Unverständnis für „dieses lästige Informatik-Gequatsche“ und dem verheerenden Digitalisierungsnotstand in Deutschland. Damit muss endlich Schluss sein.

Wir brauchen mehr Aufklärung, bessere Bildung, mehr Information aber auch beherzte Diskussionen zur Primetime. Ich bin für viele Initiativen offen, daher: sprechen Sie mich an, wenn Sie das auch so oder so ähnlich sehen. Oder laden Sie mich als Redner ein, der Ihnen und Ihrem Publikum genug Gedankenfutter für die kommenden Jahre auf den Weg gibt.

* auf Deutsch und Englisch steckt ja das Kürzel für Künstliche Intelligenz in meinem Vornamen. Vielleicht ist es aber auch kein Zufall!?

** Der Vollständigkeit halber für meinen Sprachfimmel: Künstliche Intelligenz wird die Zukunft genauso wenig verändern wie alles andere. Sie wird sie aber prägen.

Photo by Morning Brew on Unsplash

Andere Blogbeiträge

23/12/2024

Zukunftsforscher-FAQ (Teil 2)

19/08/2024

FAQ eines Zukunftsforschers

13/05/2024

Kai Gondlach im RTL Nachtjournal

08/03/2024

Buch „KI jetzt!“ erscheint bald!

2 Comments

Add comment Antworten abbrechen

Du musst angemeldet sein, um einen Kommentar abzugeben.

Künstliche Dummheit ist glaube ich immer noch angesagt. Leider sehen wir nur wenige grössere Fortschritte in dieser Welt und viele Fails da einfach der disconnect zwischen „Erwartung“ und „Erfüllbarkeit“ noch gegeben ist.

Speziell aber mit den neuesten Entwicklungen der Quantentechnologien kann hier einiges an Möglichkeiten enstehen, um endlich umfassendere AI zuzulassen. Glaube dann wird es wirklich spannend und ist nicht nur Excel-ähnlich (wie 99% der Lösungen die derzeit am Markt sind bzw. eingesetzt werden)

Ich glaube auch, dass menschliche Dummheit (aka Schwarmdummheit) nach wie vor das größere und offenbar dringendere Problem ist. Das wiederum ließe sich zumindest zum Teil durch KI-Systeme eindämmen, wenn es Chatbots gäbe, die nicht nur Falschinformationen teilen, sondern auf dumme (aka rassistische, sexistische, xenophobe, etc.) Äußerungen im Internet klug reagieren würden.