Wie wird Künstliche Intelligenz die Zukunft verändern?

Zu diesem Thema werde ich immer häufiger als Keynote Speaker angefragt. Das hat verschiedene Gründe – ich hoffe, dass mein Vorname* keiner davon ist. Es hat eher etwas damit zu tun, dass ich 1. Zukunftsforscher und 2. Hobby-IT-Nerd bin. 3. werden nur wenige technologische Entwicklungen unserer Zeit gleichzeitig derart über- und unterschätzt.

Eine derart globalgalaktische Fragestellung lässt sich in einem kurzen Blogbeitrag nur unbefriedigend beantworten. Aber ich möchte Ihnen gern ein Gefühl dafür geben und mir gleichzeitig Mühe, mich kurz zu fassen und trotzdem nicht zu viel auszuklammern.

Was ist Künstliche Intelligenz (KI)?

Bevor wissenschaftlich geprägte Menschen sich einer Fragestellung nähern, klären wir immer erst die grundlegenden Definitionen. Bereits 1955 prägte der US-amerikanische Informatiker und Autor John McCarthy bei der „Dartmouth Conference“ den Begriff „Künstliche Intelligenz“. Theoretisch wurde natürlich bereits vorher über die potenziellen Denkfähigkeiten von Maschinen spekuliert, an der Stelle ist in erster Linie Alan Turing zu nennen. Dieser entwickelte auch den Turing-Test, welcher feststellen soll, ob eine Maschine in der Kommunikation noch von einem Menschen zu unterscheiden ist oder nicht. Der Turing-Award wiederum wird seit 1966 jährlich verliehen und ist so etwas wie der Nobelpreis für Informatiker:innen.

Künstliche Intelligenz ist dem Gehirn nachempfunden

Seit fast 70 Jahren steht nun also der Begriff Künstliche Intelligenz im Raum, doch praktisch hat die Entwicklung erst seit der Jahrtausendwende Fahrt aufgenommen. Das hat viel mit dem Geschwindigkeitsanstieg von Computerchips zu tun (s. Moore’sches Gesetz). Denn die Grundlage für KI ist natürlich genau das: sehr schnelle Rechenmaschinen, die in kurzer Zeit viele Daten verarbeiten können. Der Grundgedanke dahinter ist die Annahme, dass unser Gehirn letztlich auch nichts anderes tut als sehr viele Reize (= Daten), die permanent auf uns einprasseln, schnell zu verarbeiten. Wir nutzen dafür die Macht der Neuronen und Synapsen zwischen unseren Ohren; ein Computer nutzt dafür seinen Prozessor (CPU oder GPU) und die Festplatte (oder andere Speichereinheiten).

In unserem Hirn feuern die Synapsen in atemberaubender Geschwindigkeit, wenn bspw. ein optischer Reiz vom Auge ans Gehirn gesendet wird. Diverse Prozesse des Gehirns prüfen zunächst, ob der Reiz eine Bedrohung darstellt, ordnet den Reiz sodann in bekannte Muster ein und aktiviert die Datenverarbeitung – beispielsweise, um eine Handlung auszuführen oder erst einmal ausgiebig darüber nachzudenken. Jeder Mensch hat dafür seine eigenen Muster und Vorurteile, was auch einen Teil meines Slogans „Zukunft ist eine Frage der Perspektive“ begründet. Für die Thematik der Künstlichen Intelligenz ist für uns aber wichtiger, dass diese Datenverarbeitung unseres Gehirns schrittweise von der Informatik (und Kybernetik) imitiert wird, um automatisierte Denkmaschinen herzustellen. Manche sprechen bereits von Leben 3.0 (vor allem der MIT-Professor Max Tegmark), also einer synthetischen Form des Lebens, die sich ihrer selbst bewusst werden und nach eigener Agenda handeln könnte.

Definition Künstliche Intelligenz (EU)

Es ist nicht leicht, eine geeignete Definition Künstlicher Intelligenz zu finden. Ich habe mich für die Variante der High-Level Expert Group on Artificial Intelligence der Europäischen Kommission entschieden:

„Künstliche-Intelligenz-(KI)-Systeme sind vom Menschen entwickelte Software- (und möglicherweise auch Hardware-) Systeme, die in Bezug auf ein komplexes Ziel auf physischer oder digitaler Ebene agieren, indem sie ihre Umgebung durch Datenerfassung wahrnehmen, die gesammelten strukturierten oder unstrukturierten Daten interpretieren, Schlussfolgerungen daraus ziehen oder die aus diesen Daten abgeleiteten Informationen verarbeiten und über die geeignete(n) Maßnahme(n) zur Erreichung des vorgegebenen Ziels entscheiden. KI-Systeme können entweder symbolische Regeln verwenden oder ein numerisches Modell erlernen, und sind auch in der Lage, die Auswirkungen ihrer früheren Handlungen auf die Umgebung zu analysieren und ihr Verhalten entsprechend anzupassen.“

zitiert nach: Europäische Kommission (2020): Weißbuch: Zur Künstlichen Intelligenz – ein europäisches Konzept für Exzellenz und Vertrauen, S. 19. Online: https://ec.europa.eu/info/publications/white-paper-artificial-intelligence-european-approach-excellence-and-trust_en (Abruf am 20.01.2021)

Kurz: KI-Anwendungen sind technische Einrichtungen, die computergestützt Daten verarbeiten und autonom Entscheidungen treffen.

Kurz und laiengerecht: KI ist nicht, wenn eine Maschine etwas kann, was bisher nur Menschen konnten. KI ist, wenn eine Maschine etwas kann, aber niemand genau versteht, warum.

Was ist Künstliche Intelligenz nicht?

Intelligent.

Vieles im Feld der künstlichen Intelligenz wirkt geradezu magisch, wenn man die Grundlagen nicht durchdrungen hat. Das ist auch nicht schlimm, dafür haben Sie ja mich. Maschinen vollbringen zwar bereits Wunder, doch hat das wenig mit der „Intelligenz“ der Maschine zu tun.

Schwache Künstliche Intelligenz

Die wichtigsten Felder der Künstlichen Intelligenz tummeln sich unter dem Begriff des Maschinellen Lernens (inkl. Maschine Learning, Deep Learning, Artificial Neural Networks). Das Prinzip des Maschinellen Lernens (ML) orientiert sich zwar an Lernvorgängen biologischer Wesen, doch wird in der Regel sehr klar vorgegeben, was die Maschine erledigen und wie sie lernen soll (hier unterscheidet man noch das überwachte und unüberwachte Lernen). Dabei geht es bislang immer um sehr spezifische Problemstellungen, die von der Maschine gelöst werden sollen. Es ist also eine schwache Intelligenz (engl. narrow artificial intelligence).

Starke Künstliche Intelligenz

Das Ziel der Entwicklung, gewissermaßen der „heilige Gral“ der KI-Forschung, ist zwar die allgemeine KI (engl. artificial general intelligence). Doch davon sind wir noch viele Jahrzehnte bis Jahrhunderte entfernt; manche nehmen sogar an, dass dieser Schritt unmöglich ist. Dazu müsste nämlich die Maschine ein Bewusstsein entwickeln – und wir müssten das auch erkennen. Der aktuelle Pfad zeigt in eine vollkommen andere Richtung: Menschen entwickeln begrenzt intelligente Maschinen, um die Probleme der Menschen und der Umwelt zu lösen. Ich habe weniger Angst vor einer bösartigen Künstlichen Intelligenz nach dem Terminator-Vorbild als vor einem irren Diktator, der perfekt trainierte Killermaschinen in den Krieg sendet. Daher befürworte ich auch ein Moratorium von KI-Systemen in bestimmten Bereichen, darunter auch Kriegsführung.

Schauen wir uns ein paar wichtige Meilensteine der Künstlichen Intelligenz an, um zu verstehen, wo wir stehen.

Status Quo (ausgewählte Use Cases)

Seit gut zehn Jahren überschlagen sich die Meldungen über Durchbrüche in der KI-Entwicklung. Ich habe ein paar Schlaglichter für Sie ausgewählt, mit denen Sie mindestens im Freundeskreis, vielleicht sogar in der Geschäftsführung punkten können:

2011: IBM Watson gewinnt bei Jeopardy

Der von IBM entwickelte Supercomputer Watson wurde 2011 auf die zwei besten menschlichen Kandidaten in der Quizshow Jeopardy losgelassen. Die Show funktioniert so, dass die Moderation eine Antwort nennt und die Kandidat:innen die gesuchte Frage finden müssen. Watson wurde darauf trainiert, alle vorigen Sendungen mit einer Lexikon-Datenbank zu verknüpfen sowie natürliche Sprache zu verstehen. Darüber hinaus wurde er mit einer begrenzten Risikobereitschaft ausgestattet, denn bei derart offenen Fragestellungen kann man nicht immer auf die hundertprozentige Gewissheit warten, bis man den Buzzer drückt. Sie ahnen bereits, wer als Sieger aus dem Spiel ging: Watson. Schauen Sie selbst:

Das ist nett, doch für die echte Welt noch wenig hilfreich. Das hat sich schon bald geändert, als Watson bereits 2013 für den Einsatz in der Onkologie weiterentwickelt wurde. Seither gilt Watson als bester Krebsdiagnostiker der Welt dank seiner übermenschlichen Fähigkeit, beliebig viele Daten zu kombinieren und bspw. MRT-Bilder von Patienten mit der Datenbank bekannter Krebsarten zu korrelieren. Das Ergebnis seiner Berechnung erscheint nach wenigen Sekunden auf dem Tablet des behandelnden Arztes, der sehr viel schneller und effizienter eine Aussage treffen und ggf. eine Therapie wählen kann:

2011: Sprachassistenten auf dem Vormarsch

Sprechen Sie gelegentlich mit Siri, Alexa, Hey Google, Cortana oder Bixby? Das sind die beliebtesten Sprachassistenten, die inzwischen von ungefähr drei Vierteln der in Deutschland lebenden Menschen genutzt werden – sogar beim Banking. Die Grundlage ist das sogenannte Natural Language Processing (NLP), also die Verarbeitung natürlicher Sprache. Da wenige Menschen eine komplett korrekte Aussprache haben, mussten die Assistenten lernen, Dialekte zu erkennen, Betonungen zu gewichten und all das, was unser Ohr und Gehirn sonst für uns übernimmt zu lernen. 2011 kam Siri auf den Markt und war noch vergleichsweise dumm, konnte nur eine kleine Bandbreite vorgefertigter Sprachbefehle verarbeiten – und das nur dann, wenn der Mensch sehr deutlich gesprochen hat. Das hat sich seither geändert, weil inzwischen Milliarden bis Billionen Aufnahmen verarbeitet und analysiert wurden, um daraus neue Muster zu erkennen. Daraus entsteht für die Nutzer:innen ein klarer Vorteil, nicht zuletzt für wenig technikaffine Menschen sind Sprachassistenten ein einfacher Zugang zu Technologie, bspw. um im Smart Home Licht, Musik oder Temperatur sowie im modernen Fahrzeug das Navigationssystem freihändig zu steuern.

Andere Anwendungen kombinieren die Sprach- mit der Stimmanalyse, um Marker in der Stimme zu analysieren und wahlweise den emotionalen Zustand (engl. affective AI), psychologische Grundbedingungen oder schwere Erkrankungen darin zu erkennen.

2016: AlphaGo bezwingt den besten Go-Spieler

Als ein Schachcomputer 1997 gegen den damaligen Weltmeister Garry Kasparov gewann, staunte die Welt. Das hatte nur bedingt etwas mit KI zu tun, weil Schach zwar einerseits als Spiel der Könige ein gewisses Strategieverständnis voraussetzt, letztlich aber vor allem Erfahrung und Vorausdenken kommender Kombinationen und Zwänge des Gegners erfordert. Das war relativ leicht programmiert. Anders sieht es beim chinesischen Brettspiel Go aus, in dem es ungleich mehr Kombinationen gibt (mehr als Atome im Universum). Man kann einer Maschine nach heutigem Stand nicht alle möglichen Kombinationen beibringen, weil das Brett größer und die Funktionen der Figuren weniger determiniert sind. Deshalb dachten selbst führende KI-Expert:innen bis 2016 auch, dass es noch mehrere Jahre oder Jahrzehnte dauern würde, bis ein Computer gegen einen menschlichen Go-Spieler gewinnen könnte. Sie lagen falsch.

In einem atemberaubenden Duell trat der damals beste Spieler Lee Sedol gegen AlphaGo an, welches von Alphabet (Googles Mutterkonzern) entwickelt wurde. Der Computer gewann deutlich mit 4:1 und verblüffte vor allem durch seine Kreativität; einige Spielzüge konnte die Fachwelt und die Kommentatoren einfach nicht einordnen. Sie erschienen zunächst irrational, haben sich aber viele Runden später als raffinierte taktische Manöver entpuppt. Inzwischen gibt’s sogar eine Dokumentation zu AlphaGo:

Auch hier stellt sich wieder die Frage, wo der Sinn in einer Maschine liegt, die Menschen in ihren eigenen Spielen schlagen. Ganz einfach; AlphaGo wurde bald zu AlphaFold und begann, die grundlegenden Muster der Biologie zu erforschen. Die KI bzw. das maschinelle Lernen von AlphaFold erreichte Ende 2020 den Durchbruch und sagte die Proteinstruktur basierend auf der Aminosäuresequenz des Proteins voraus; eine 50-Jahre alte Herausforderung der Biologie. Wozu nützt das? Viele Krankheiten sind direkt mit Proteinfunktionen verknüpft, darunter Krebs und Demenz. Das bedeutet, nun können Forscher:innen besser Krankheiten verstehen und hoffentlich bald wirksame, potenziell auch individualisierte Gegenmittel dazu entwickeln:

Ein ähnliches Verfahren wurde übrigens von Pharmazieunternehmen angewandt, um Gegenmittel für Covid-19 zu entwickeln. Bedeutet in kurz: Künstliche Intelligenz beschleunigt die Forschung und Entwicklung in der Medizin und Pharmakologie enorm.

2019: Bildmanipulation in (bald) Echtzeit mit StarGAN v2

In Zeiten von Fehlinformationskampagnen und Fake News fehlte gerade noch eine Software, die beliebige Bilder manipulieren kann. Donald Trump zeigt den Hitlergruß? Kein Problem, StarGAN kann das. Hitler umarmt Barack Obama? Auch das dürfte kein Problem sein, doch spätestens hier würden historisch Gebildete den Fehler bemerken. Das ist leider nicht immer so, da die Fälschungen immer besser werden. Mitschuld daran trägt die Technologie „StarGAN“ (das GAN steht für „Generative Adversarial Networks“). 2019 haben Forscher:innen das erste Mal diese Netzwerke antrainiert und vorgeführt, die Weiterentwicklung wurde bereits wenige Monate später unter Open Access veröffentlicht. Sehen Sie hier, was die KI kann:

In wenigen Jahren erwarte ich daher Film- und Serienproduktionen, die komplett ohne Set und Schauspieler:innen produziert wurden – und dennoch mit realistischen Figuren bestückt sind. Und wer weiß, vielleicht werde ich auch meine Vorträge mit StarGAN automatisieren?!

2020: Textautomatisierung mit GPT3

Schließlich ein wichtiger Durchbruch auf dem Gebiet der automatisierten Texterstellung. Das Kürzel GPT3 steht für „Generative Pre-trained Transformer 3“ und ist die Weiterentwicklung eines von OpenAI initiierten Projekts, um Texte von KIs schreiben zu lassen. Die beiden Vorläufer waren schon erstaunlich, doch GPT3 toppt alles vorher Dagewesene. Die britische Tageszeitung „The Guardian“ hat einen kompletten Artikel aus der „Feder“ von GPT3 veröffentlicht:

https://www.theguardian.com/commentisfree/2020/sep/08/robot-wrote-this-article-gpt-3

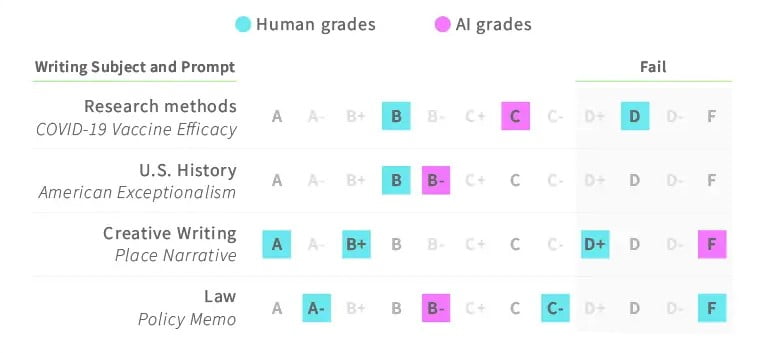

Kurz darauf traten Studierende gegen GPT3 in einen Wettbewerb um das bessere Essay – raten Sie, wer gewann: https://mixed.de/openai-gpt-3-vs-studis-wer-kriegt-die-besseren-noten/

… genau, die KI. Professor:innen haben den Unterschied nach kleineren Anpassungen nicht festgestellt:

Lustige Anwendungen

KI-Anwendungen werden auch oft noch eher experimentell und vor allem von einer großen Community von IT-Geeks entwickelt. Diese Seite listet kostenlose, meist unterhaltsame Anwendungen auf – darunter ein Kunstsimulator, eine Songtexte-KI oder KI-colorierte Filmklassiker: https://boredhumans.com/

Business-Anwendungen

In meinen Vorträgen zeige ich auch je nach Kontext aktuelle Anwendungen aus den Bereichen Justiz, Personalwesen, Mobilität (v.a. autonomes Fahren), Bildung, Handwerk, Medizin, Maschinenbau (und viele mehr) und was eben gerade passt. Das würde hier aber den Rahmen sprengen. Ich würde behaupten, dass es keine größere Branche gibt, in der es nicht bereits Anwendungen gibt, die Prozesse mithilfe von KI automatisieren oder autonomisieren. Gleichzeitig arbeiten KI-Forscher:innen weltweit daran, KI-Anwendungen erklärbar zu machen – subsumiert unter dem Stichwort explainable / intelligible AI (erklärbare oder sich selbst erklärende KI).

Nehmen Sie gern Kontakt auf, wenn Sie eine individualisierte Zusammenstellung in Keynote-Form interessiert.

Ausblick 2050: Transmodern Liberty

Was kommt danach?

Klassischerweise schauen Zukunftsforscher:innen eher 5-10 Jahre in die Zukunft. Aber dazu erscheint dieses Jahr noch ein Buch, dessen Mitherausgeber ich bin („Arbeitswelt und Künstliche Intelligenz 2030“). Daher möchte ich hier den Blickwinkel auf die fernere Zukunft richten: 2050.

Die Schnittstelle von KI-Anwendungen ist: Bei dieser Welle der Industrialisierung geht es nicht (nur) darum, physische Körperkraft auf Maschinen zu übertragen, sondern auch kognitive Fähigkeiten. Daher sind auch hochqualifizierte Akademiker:innen nicht sicher vor Automatisierungstendenzen. Die Auswirkungen davon können sehr vielseitig sein und werden je nach Wirtschafts- und Gesellschaftskontext in den nächsten Jahrzehnten sehr unterschiedlich bewertet werden. In den meisten industrialisierten Volkswirtschaften ist ein (bedingungsloses) Grundeinkommen sehr wahrscheinlich – nicht zuletzt, da es von der aktuellen Wirtschaftselite sogar vorangetrieben wird. Wer zahlt die Steuern? Na, die Roboter und Algorithmen!

Mein Zukunftsbild im technologischen Bereich nennt sich „Transmodern Liberty“. Der Begriff setzt sich aus den Elementen einer Transmodernen Gesellschaft sowie einer neuen Qualität des Freiheitsbegriffs zusammen und ist eine optimistische Variante der Zukunft. Mein Szenario beinhaltet unter anderem folgende Aspekte:

Technologie macht Menschen menschlich

Was widersprüchlich klingt, ist mein voller Ernst. Der richtige Einsatz der Technologie, allen voran Künstliche Intelligenz, könnte im besten Fall dazu führen, dass erstmals in der Geschichte der Menschheit alle Menschen menschlich sein dürfen. Was heißt menschlich? Für mich heißt das, sich nicht tagtäglich um die Versorgung existenzieller Bedürfnisse kümmern zu müssen. Dieses Privileg war seit Beginn der Menschheit (wenn überhaupt) einer kleinen Elite vorbehalten. Doch wenn die Grundbedürfnisse durch automatisierte Prozesse gedeckt werden können, entsteht zumindest die Möglichkeit, dass Erwerbsarbeit obsolet wird – stattdessen gehen Menschen „arbeiten“, weil es ihren individuellen Stärken und Interessen entspricht und sie dadurch einen Beitrag zur Gesellschaft leisten.

Sapiens 2.0 wird geboren

Oft spreche ich in meinen Vorträgen über den Homo Prospectus als zukunftsdenkenden Menschen. Das ist ein Bestandteil einer neuen Form der Menschlichkeit; damit sind nicht genetisch optimierte Menschen gemeint, sondern diejenigen mit einem kosmopolitischen Mindset und dem Verständnis der Transmodern Liberty. Sie basieren auf einer aktualisierten Fassung der Aufklärung und des Humanismus, erkennen jegliches Leben als gleichwertig an und sind ohne äußere Zwänge frei in der Entfaltung der eigenen Biographien.

Automatisierung der Diplomatie und Global Governance

Neben der Produktion alltäglicher Güter und der Infrastruktur muss natürlich auch die Staatsführung automatisiert werden. Wem nützt es, wenn innerhalb einiger geschlossener Nationalstaaten die Wirtschaft automatisiert wird, der Nachbarstaat aber regelmäßig diplomatische Krisen verursacht oder Spitzenbeamten und -politiker:innen korrupt sind? Eben. Hier erkennen wir zunehmend den Trend zu einer echten Tianxia, also einem global inklusiven Politiksystem: Es erkennt einerseits die kulturellen und historischen Verschiedenheiten der Menschen und Territorien an, nivelliert andererseits aber menschliche Abgründe wie Gier, Hass oder Rache durch kluge Diplomatie. Wenn ein Computer im Go gegen einen Menschen gewinnt, wird er jawohl auch bald eine diplomatische Krise moderieren können. Fragen Sie mal die Menschen in Krisen- und Kriegsgebieten, die haben schon heute keine Lust auf Terror.

Zurück in die Gegenwart

Künstliche Intelligenz wird die Welt mindestens genauso stark verändern wie Strom oder die Bändigung des Feuers. Das sage nicht ich, sondern Google CEO Sundar Pichai 2018, doch ich stimme ihm zu. Gleichzeitig setze ich mich dafür ein, mehr Aufklärung zu schaffen und das Thema zu entmystifizieren. Die Erwartungen für das laufende Jahrzehnt reichen von der Angst vor einem Terminator-Szenario oder Komplettautomatisierung bis zu Unverständnis für „dieses lästige Informatik-Gequatsche“ und dem verheerenden Digitalisierungsnotstand in Deutschland. Damit muss endlich Schluss sein.

Wir brauchen mehr Aufklärung, bessere Bildung, mehr Information aber auch beherzte Diskussionen zur Primetime. Ich bin für viele Initiativen offen, daher: sprechen Sie mich an, wenn Sie das auch so oder so ähnlich sehen. Oder laden Sie mich als Redner ein, der Ihnen und Ihrem Publikum genug Gedankenfutter für die kommenden Jahre auf den Weg gibt.

* auf Deutsch und Englisch steckt ja das Kürzel für Künstliche Intelligenz in meinem Vornamen. Vielleicht ist es aber auch kein Zufall!?

** Der Vollständigkeit halber für meinen Sprachfimmel: Künstliche Intelligenz wird die Zukunft genauso wenig verändern wie alles andere. Sie wird sie aber prägen.

Photo by Morning Brew on Unsplash

#01.08 Perspektiven 2021: Rückblick und Ausblick Im Hier und Morgen

Das zurückliegende Jahr ist bereits in die Geschichte eingegangen als das "Jahr der Pandemie". Viele negative Schlagzeilen beherrschten die Medien: neben Corona gab es politische Konflikte, Hungersnöte, Kriege und die Klimakatastrophe zeigte ihre Auswirkungen auch im "globalen Norden". Kein Grund, den Kopf in den Sand zu stecken! In meinem Ausblick auf 2021 hebe ich auch die Errungenschaften des Jahres hervor und entwickle verschiedene Perspektiven auf das neue Jahr.

Jetzt anhören auf Spotify:

Anhören auf Soundcloud:

Anhören auf Itunes:

Anhören auf Deezer:

https://www.deezer.com/de/episode/268227342

Anschauen auf Youtube:

#01.03 Was ist und kann Künstliche Intelligenz? KI Im Hier und Morgen

In dieser Episode bearbeite ich die wichtigsten Grundlagenfragen für Anfänger*innen im Gebiet Künstliche Intelligenz. Vorab habe ich dazu Freunde, Familie und Bekannte nach den dringenden Themen gefragt - darunter die fundamentalen Begrifflichkeiten, aber auch Bedenken wie "wird KI meinen Job ersetzen"? Dies ist der Auftakt einer KI-Serie und vor allem für Einsteiger*innen gemacht.

Anhören auf Spotify:

Anhören auf Itunes:

Anhören auf Deezer:

https://www.deezer.com/de/episode/262714472

Anhören auf Soundcloud:

Anschauen auf Youtube:

Zukunft der Arbeit: Sonderband und Postkapitalismus

Gestern war es endlich soweit: Der Sonderband "Zukunft der Arbeit" von Prof. Dr. Jens Nachtwei und Antonia Sureth wurde veröffentlicht! 122 Fachartikel von 181 Autor*innen - das Themenspektrum reicht von (alternativen) Arbeitswelten über Bildung und Personalwesen, Organisation & Kollaboration und Führung zu technologischen Themen wie Künstlicher Intelligenz im Arbeitskontext. Natürlich gibt es auch Praxisbeispiele. Und das beste: der Band ist kostenlos verfügbar!

Achso, und: ich habe auch einen Beitrag geleistet: "Postkapitalismus: Systemfragen der 4. Industriellen Revolution" (S. 54-57). Hier geht's direkt zur Publikation:

www.SonderbandZukunftDerArbeit.de

Für Zitation bitte folgende Form verwenden:

- Nachtwei, J., & Sureth, A. (Hrsg.). (2020). Sonderband Zukunft der Arbeit (HR Consulting Review, Bd. 12). VQP.

https://www.sonderbandzukunftderarbeit.de- Gondlach, K. A. (2020). Postkapitalismus: Systemfragen der 4. Industriellen Revolution. In J. Nachtwei & A. Sureth (Hrsg.), Sonderband Zukunft der Arbeit (HR Consulting Review, Bd. 12, S. 00-00). VQP. https://www.sonderbandzukunftderarbeit.de

Veröffentlichungsreihe

Die Veröffentlichungsreihe für Qualitätssicherung in Personalauswahl und -entwicklung (VQP) wurde 2012 zur Förderung des Austauschs von Forschung, Lehre und Praxis begleitend zur Vorlesung Personal- und Organisationsberatung von Jens Nachtwei am Institut für Psychologie der Humboldt-Universität zu Berlin ins Leben gerufen.HR Consulting Review

Im Herausgeberband HR Consulting Review der Veröffentlichungsreihe stellen Praktiker*innen und Forscher*innen Projekte, Modelle und Sichtweisen sowie wissenschaftliche Studien vor. Die Themen stammen vorwiegend aus den Bereichen Führung, Personalauswahl, Personalentwicklung und Organisationsentwicklung.

Freier Zugang zu wissenschaftlichen Erkenntnissen bedeutet nicht, dass sie umsonst sind. Die Organisator*innen und Autor*innen haben überwiegend ehrenamtlich viel Zeit und Mühe in die Erstellung dieses Bands gesteckt. Bitte quittieren Sie diesen Dienst durch Verbreitung der Publikation, kritische Auseinandersetzung und proaktive Diskussion oder finanzielle Unterstützung der jeweiligen Institutionen. Danke!

10/2020: Zukunft: Eine Frage der Perspektive (Hannoversche Volksbank)

Am 6. Oktober 2020 habe ich für die Privatkunden der Hannoverschen Volksbank einen Ausflug in die Zukunft gewagt. Oder eher Zukünfte? Ein bunter Themenmix aus Mobilität, Gesundheit, künstlicher Intelligenz und Gehirn-Implantaten erwartet Sie. Und ganz wichtig: Warum sind die unterschiedlichen Perspektiven auf Zukünfte so wichtig? Was kann uns dabei helfen, angesichts der erschreckenden Entwicklungen auf dem Planeten Zuversicht zu bewahren? Finden Sie es heraus in meinem Vortrag „Zukunft: Eine Frage der Perspektive“!

Sie planen auch ein Event und möchten mich als Impulsgeber für Ihre Kunden, Mitarbeiter oder Mitglieder buchen? Kein Problem, schreiben Sie mir gern direkt Ihre Anfrage:

Das Ende der Globalisierung?!

Im Juni habe ich mir ein Lesezeichen für eine Studie von Prognos AG und BayernLB gesetzt: "Das Ende der Globalisierung - braucht Deutschland ein neues Geschäftsmodell? Wie Unternehmen jetzt die Weichen richtig stellen". Diese ist meiner Meinung nach untergegangen, aber dafür gibt es natürlich gute Gründe. Nennen wir es das C-Argument. Da die Studie aber wirklich wichtig ist, möchte ich dazu meine Zukunftsforscher-Einschätzung teilen.

Kernaussage der Studie ist: Deutschland braucht ein neues Geschäftsmodell und das "Ende der Globalisierung" sei erreicht. In der Studie werden natürlich auch Wege aus dem Dilemma besprochen, die Lektüre empfehle ich nachdrücklich. Nun aber zu meiner pointierten Einschätzung.

Zustimmung: Deutsche Unternehmen verschlafen den Wandel

Unternehmen in Deutschland sind durchschnittlich zu konservativ, zu unambitioniert und neigen zu blinder Pfadabhängigkeit, wenn es um ihre langfristigen Strategien geht. Nach dem Motto "haben wir schon immer so gemacht!" konzentriert man sich hierzulande gern an den bestehenden Lieferantenbeziehungen und Absatzmärkten (sorry für die Plattitüde, das trifft sicherlich nicht auf alle zu - hier schreibe ich über die träge oder angsterstarrte Mehrheit). Diverse Studien und Dossiers attestieren und bemängeln, dass Digitalisierung in Deutschland nach wie vor auf Kosten der nationalen Wirtschaftsleistung und des BIP stiefmütterlich behandelt wird, vor allem zulasten des internationalen Wettbewerbs um die Vorherrschaft der digitalisierten Weltökonomie.

Ein Beispiel: Oft ist die Rede davon, dass wir bereits die zweite Halbzeit der Digitalisierung verloren hätten. Das klingt so, als wäre das Spiel bereits vorbei - das ist nicht ganz richtig. Es verdeutlicht aber anhand der klassischen Rasensportmetapher, dass "wir" nicht mehr gewinnen können. Diese Befürchtung teile ich, wenn man "normale" Rahmenbedingungen voraussetzt und die Gewinnbedingungen klar definiert. Aber: Wie wir alle wissen, sind diese aber im Jahr 1 nach Corona die Spielregeln andere als gewöhnlich, weshalb sich die wissenschaftliche Zukunftsforschung aktuell mit Prognosen zurückhält und primär (oft normative) Szenarien formuliert. Ebenso werden auch die Karten in puncto Digitalisierung neu gemischt. Insbesondere die ohnehin bereits vorreitenden Hightech-Konzerne nutzen die Ausnahmesituation, um ihre Produkte und Lösungen in noch mehr Märkte zu bringen und Steueroasen noch rücksichtsloser auszunutzen. Und an der Stelle wird deutlich, dass der Vorsprung dieser Giganten, die ich gern mit den beiden Akronymen G-MAFIA (Google/Alphabet, Microsoft, Apple, Facebook, IBM, Amazon) und BAT (Baidu, Alibaba, Tencent) abkürze, Globalisierung besser verstanden haben als etwa deutsche Unternehmen. Diese neun Unternehmen investierten bereits vor der Covid19-Krise teilweise mehr Geld in die Entwicklung Künstlicher Intelligenz als die Bundesrepublik Deutschland; glauben wir dem Mooreschen Gesetz der exponentiellen Effizienzsteigerung der IT, verdoppelt sich der Vorsprung der Maschinen (und hier sehe ich auch KI-Algorithmen und deren Leistung) etwa alle zwei Jahre. Das bedeutet, dass sich der Vorsprung des internationalen Wettbewerbs ebenfalls exponentiell vergrößert, je länger Unternehmen hierzulande warten.

Also: Höchste Zeit für Veränderung!

Ablehnung: Globalisierung hat gerade erst begonnen!

Der Titel der Prognos-Bayern LB-Studie "Das Ende der Globalisierung" erinnert sicherlich nicht durch Zufall an das Buch von Francis Fukuyama "Das Ende der Geschichte", das nach dem Zusammenbruch der UdSSR herauskam und den Sieg des Kapitalismus über den Kommunismus proklamierte. Danach kam alles anders, wie wir wissen, und die Geschichte war natürlich nicht zu Ende. Auch nicht die Auseinandersetzung konfligierender Wirtschaftsordnungen. Ebenso wenig ist das Ende der Globalisierung erreicht (selbstverständlich ist das auch nicht die einzige Aussage der hier behandelten Studie).

Erstens sollte die Kernaussage der Studie vielmehr sein, dass die klassischen Absatzmärkte und Erlösströme insbesondere für die deutsche Wirtschaft deutliche Anzeichen einer Sättigung zeigen. Hinzu kommt, dass der Anteil intangibler Produkte (Lösungen, Dienstleistungen und digitale Geschäftsmodelle) ungebremst ansteigt. Und, was der deutschen Erfinderseele Kopfzerbrechen bereitet: die wertvollsten Geschäftsmodelle der letzten Jahrzehnte wurden allesamt außerhalb Deutschlands entwickelt und höchstens hier kopiert. Einige behaupten sogar provokant, dass seit der Entwicklung des Automobils keine größere, wertvolle Erfindung mehr aus Deutschland kam. Kennen Sie ein Gegenbeispiel?

Zweitens ist die Globalisierung natürlich nicht am Ende. Auch wenn dies der Titel lediglich suggerieren soll und der Volltext der Studie besser aufklärt, möchte ich hier vehement widersprechen. Nur weil die klassischen Absatzmärkte der "Ersten Welt" gesättigt sind und die deutschen Produkte keinen Anklang mehr finden, heißt das noch lange nicht, dass die Nachfrage weltweit gedeckt ist. Aufstrebende Ökonomien (insb. Indien, Irak, Philippinen, Vietnam und Ägypten) verzeichnen einen stark steigenden Bedarf an Produkten und Lösungen der zweiten und dritten Industrie-Zeitalter. Einige von ihnen wiederum haben den Begriff Leapfrogging bzw. Reverse Engineering geprägt: Zwischenschritte der technologischen Entwicklung werden schlicht übersprungen. So verfügen einige afrikanische und südostasiatische Staaten kaum über klassische Überland-Telefonverbindungen, Einwohner*innen können jedoch über Handys und Smartphones aufs mobile Netz zugreifen. Außerdem ist die Globalisierung der Wirtschaft nach klassischer Lesart noch lange nicht beendet, man muss sich nur die Entwicklung von IoT- (Internet der Dinge) und Smart City-Lösungen ansehen. Schade, dass auch hier nur wenige deutsche Unternehmen in der ersten Reihe tanzen.

Drittens würde ich weniger vom Ende der Globalisierung als vom Ende des Kapitalismus in seiner jetzigen Form sprechen. Kapitalismus zeichnet sich dadurch aus, dass er sich durch Krisen eher mithilfe von "Mutationen" an die neuen Gegebenheiten anpasst. Er ist sozusagen agiler als kommunistische oder sozialistische Modelle, die bislang an der Realität gescheitert sind. Was wir jetzt nicht brauchen, ist ein Erstarken der kommunistischen Idee - immerhin stammt diese aus der Zeit vor der Globalisierung, welche wir aber nicht mehr zurückdrehen können und daher mit dem alten Welt-Entwurf eher in die vorindustrielle Zeit zurückkatapultiert wären. Die Idee mag vereinzelt Zuspruch finden, dürfte aber weit mehr Existenzen gefährden als absichern. Was wir brauchen, ist ein globaler Dialog über eine neue Form des Kapitalismus, oft Postkapitalismus oder postmoderner Kapitalismus genannt. Dazu gehören neue Formen einer Regulierung von internationalen Monopolen, (strafrechtliche) Verfolgung von digitalen Verbrechen, Fake news oder Hatespeech und natürlich eine Bepreisung negativer ökologischer Fußabdrücke.

Ergänzung: Exnovation und echte Weltpolitik

Alle Welt bemängelt immer einen niedrigen Innovationsgrad von Unternehmen oder Volkswirtschaften. Dass eine zentrale Herausforderung der Menschheit genau das Gegenteil verlangt, wird dabei fast immer übersehen. Ich rede von Exnovation (darüber habe ich in meinem Zlog schon mal aufgeklärt). Exnovation heißt, sich von unnötigen Altlasten und vergangenen Innovationen zu verabschieden, wenn diese ihren Zweck nicht mehr erfüllen. Es ist die bewusste Entfernung schädlicher Lösungen. Dazu gehören einige etablierte, (noch) sehr umsatzstarke Wirtschaftszweige wie die karbonisierte Energie- und Mineralölwirtschaft, die mittelbaren Massenbranchen wie die Automobil- und Luftfahrtindustrie und natürlich althergebrachte Organisationsmodelle, die zu Zeiten der ersten industriellen Revolution entwickelt wurden und vom ungelernten Fließbandarbeiter als Norm ausgingen (auch über New Work habe ich schon mal gezloggt). Die heutige Realität - und ich meine noch nicht einmal das "neue Normal" mit Covid19 - unterscheidet sich fundamental von derjenigen, die diese und weitere Innovationen hervorgebracht hat. Insbesondere "Klimawandelbeschleuniger" und Effizienzbremsen müssen jedoch so schnell wie möglich unter Einhaltung gesellschaftlicher und ökologischer Standards durch neue Lösungen ersetzt werden. Das ist die größte Herausforderung der Menschheit - nicht, wie das neue Geschäftsmodell Deutschlands aussehen soll.

Die neue Realität verlangt globale Lösungen und weniger Denken in Grenzen - sowohl politisch als auch im übertragenen Sinne ökonomisch. Also think outside the box. Alles andere wäre per definitionem Wahnsinn.

Wie?

Mehr Mut zur Veränderung und für neue Organisationsformen bei gleichzeitig verantwortungsbewusstem Umgang mit den Angestellten und der Ökologie. Ist doch ganz einfach.

Ich frage mich immer, warum so wenige Entscheider*innen hierin die win-win-Situation sehen, die so offensichtlich zu sein scheint. Systemgrenzen sind so furchtbar rigide. Die klassische "Taktik des Abwartens" ist jedenfalls eine gefährliche Karte, auf die ich nicht setzen würde.

Es wird Zeit, eine integrative, inklusive und handlungsfähige Weltpolitik und -wirtschaft zum Wohl aller Menschen zu begründen, wenn wir unseren Kindern und Enkeln einen lebenswerten Planeten hinterlassen wollen (s. auch Stichwort Tianxia). Was wir dafür brauchen? Das kann kein Mensch genau sagen. Es würde aber helfen, sich einem bewusst zu werden und dieses Bewusstsein ideell und institutionell zu verankern: jeder Mensch ist wichtig und einzigartig, unsere biologischen Grundbedürfnisse jedoch sind überall gleich - die Erfüllung dieser Bedürfnisse überall sicherzustellen, die Millennium Goals weltweit schnellstmöglich zu erreichen und Schicksale nicht in Geld umzurechnen, ist eine wichtige Bedingung, um aus dem "Ende der Globalisierung" kein "Ende der Menschheit" zu machen.

Photo by Morning Brew on Unsplash

Quantencomputer: Was, wann, wie und warum?

Sprechen wir über Quantencomputer. Wenn ich das Thema bei meinen Keynotes aufwerfe, ernte ich in der Regel verständnislose, mäßig begeisterte Blicke. "Klingt nach Magie", oder: "Bis das kommt, bin ich Rentner*in!", so die Sprüche danach. Nun sind QC in den Massenmedien angekommen, also schauen wir doch mal, was sie können (werden).

Quantencomputer sind also endlich in den Massenmedien angekommen. Warum ist die Quantenüberlegenheit (quantum supremacy) wichtig für Sie? Weil sie das Spektrum der erlaubten Fragen (und der potentiell möglichen Lösungen) erheblich erweitert! Dieser Beitrag soll das Verständnis für Quantencomputer weitertragen - und er stellt keinen Anspruch an Vollständigkeit oder technische Tiefgründigkeit, sondern richtet sich an Einsteiger. Legen wir los!

Kurzer Rückblick

Quantencomputer basieren auf der Physik der kleinsten Teilchen unseres Universum, den Quanten. Als theoretische Begründer dieser divergierenden Auffassung der "Physik von allem" gelten in erster Linie die in den 1900-30er wirkenden Physiker Max Planck, Werner Heisenberg, Max Born, Pascual Jordan und Erwin Schrödinger (bekannt durch das Gedankenexperiment "Schrödingers's Katze"). Kurios, aber inzwischen durch die Experimentalphysik nachgewiesen: Quanten lassen sich zu keinem Zeitpunkt eindeutig in ihrem aktuellen Aufenthaltsort bestimmen. Sobald Forscher ein Quantenteilchen also beobachten, lässt sich dessen genaue Position nicht mehr eindeutig nennen. Darüber hinaus treibt die Quantenmechanik das Ganze auf die Spitze, da sie die Theorien (Unschärferelation, Teilchenverschränkung, deterministische Zeitentwicklung uvm.) längst messbar macht. Kurz gesagt. Alles, was wir aus unserem Erfahrungshorizont für gegeben angenommen haben, steht plötzlich infrage. Materie ist nicht mehr fest, Teilchen haben zwei Zustände gleichzeitig und vieles mehr.

Es dauerte nicht lang, bis die aufkommende Informatik das Thema aufgriff. Deren Grundlage beruht ja bekannterweise auf der Festkörperphysik und dem Ein- und Ausschalten von Transformatoren, um binäre Zustände darzustellen. Schnelle Computer zeichnen sich dadurch aus, dass sie mit ihren Bits sehr oft zwischen 0 und 1 umschalten können. Durchschnittliche Smartphones können diesen Umschalteffekt heute ungefähr 100.000 mal schneller darstellen als der NASA-Computer der Apollo 11 Mission, der vor 50 Jahren Menschen auf den Mond gebracht hat. Würde man einen Turm aus allen aktiv genutzten iPhones weltweit bauen, käme man immerhin fast bis zur Hälfte zum Mond. Das wäre noch eine sinnvollere Verwendung der Geräte als Katzenvideos und Pornos zu streamen.

An- und Ausschalten ist der Quanteninformatik aber natürlich viel zu wenig. Wenn Quantenteilchen mehrere Zustände gleichzeitig einnehmen, müsste man das doch auch für Rechenmaschinen nutzen können. Und so gebar die Idee der Qubits (statt Bits). Qubits können theoretisch jeden sowohl 0 als auch 1 darstellen, um es einfach herunterzubrechen. Gleichzeitig steigt die Rechenleistung der Quantenprozessoren nicht nur linear mit der Anzahl der Qubits, sondern exponentiell. Heißt: Ein Quantencomputer mit 3 Qubits hat doppelt so viel Rechenleistung wie einer mit 2 Qubits. Einer mit 4 Qubits hat bereits 2*2*2 Rechenleistung. Und um das Spielchen noch komplexer zu machen, sind inzwischen auch Qutrits gelungen: ein Qutrit kann sogar drei Zustände gleichzeitig annehmen.

Warum ist das JETZT wichtig?

Kürzlich verkündete Google - erst durch einen Leak, nun auch offiziell - die Quantenüberlegenheit. Verantwortlich dafür ist Google's Quantenprozessor Sycamore, der 54 Qubits hat (bzw. 53, einer ist leider durchgebrannt). Er schlug kürzlich den schnellsten Computer der Welt in einer sehr spezifischen Aufgabe, der Errechnung tatsächlicher Zufallszahlen, um Längen. Dieser "herkömmliche" Supercomputer heißt IBM Summit und kann 122 Billiarden Mal pro Sekunde 0en und 1en ein- und ausschalten. Er benötigt (rein rechnerisch) für das Lösen der Aufgabe rund 10.000 Jahre, Sycamore 200 Sekunden.

Ja, richtig, IBM bestreitet die Überlegenheit - immerhin will IBM das Quantum Rennen gewinnen. Ja, natürlich kann dieser Quantencomputer (noch) nicht die Menschheit retten. Doch genauso funktioniert Innovation:

"So oft eine neue überraschende Erkenntnis durch die Wissenschaft gewonnen wird, ist das erste Wort der Philister: es sei nicht wahr; das zweite: es sei gegen die Religion; und das dritte: so etwas habe Jedermann schon lange vorher gewußt." (Wilhelm Raabe, 1864)*

Heißt im Klartext - und dann endet dieses lange Intro endlich: Es ist an der Zeit, sich mit der Zukunft zu befassen. Sie wird schneller zur Realität als Sie denken.

Einleitung, zweiter Anlauf

Quantencomputer beschäftigen Zukunftsforscher schon seit einigen Jahrzehnten. Sie gehörten jedoch lange Zeit zu den weit entfernten utopischen Technologien, deren Durchbruch schon mehrmals "kurz bevor" stand. Doch nun nimmt die Entwicklung endlich Fahrt auf - und die Pioniere auf dem Gebiet präsentieren immer mehr realistische Anwendungen. Schauen wir uns doch mal ein paar an, bevor wir die Perspektive Richtung Zukunftsapplikationen wenden.

Vor drei Jahren hat eines der weltweit führenden Unternehmen in der Entwicklung von Quantencomputern, D-Wave Systems Inc., einen medienwirksamen use case präsentiert. In Kooperation mit Volkswagen AG haben die Entwickler den Verkehr der jeweils nächsten 20 Minuten zwischen dem Flughafen Peking und der Innenstadt der Millionenmetropole prognostiziert. Für die Auswertung der Datenpunkte (mehrere Millionen pro Sekunde) benötigte der Quantencomputer nur wenige Sekunden, ein extrem schneller, herkömmlicher Rechner brauchte über 20 Minuten. Die Navigationssysteme der Taxifahrer wurden entsprechend informiert und die Taxis umgeleitet - mit messbaren Folgen für den Verkehr.

Fun Fact: 2017 traf ich Robert "Bo" Ewald, den Präsidenten der Firma, beim 2b AHEAD Zukunftskongress und sprach mit ihm über die Implikationen der Technologie. Einer dieser Momente, wenn sich ein Zukunftsforscher zusammenreißen muss, um nicht zu euphorisch zu werden. Er, ein offensichtlich strahlender Pionier der Entwicklung, prognostizierte: Die Quantenüberlegenheit, also der Moment, wenn ein Quantencomputer auch den schnellsten Computer der Welt deutlich schlagen würde, sei Anfang der 2020er Jahre greifbar. Und nun, im Oktober 2019, wurde sie erreicht (s.o.)! Selbst die Prognosen optimistischer Technologen werden derzeit also offenbar durch die Realität überholt. Wow!

Abseits der Euphorie stellt niemand wirklich infrage, OB Quantencomputer technologisch realisierbar sind - es ist nur eine Frage der Zeit, WANN sie ihr volles Potential entfalten werden. Wenn Sie mich fragen: innerhalb des kommenden Jahrzehnts. Sollten wir uns also heute schon darauf vorbereiten? Na gut, die Frage war suggestiv, also lassen Sie uns über die oben versprochenen, neuen Fragen sprechen, die wir stellen dürfen, wenn Rechenleistung keine Limitierung mehr darstellt.

Grundsätzlich

Die klassische Grundlagenforschung, die natürlich seit Jahrzehnten Computer einsetzt, nutzt trial & error als Hauptprinzip – als Sozialwissenschaftler erlaube ich mir mal so eine stümperhafte, alles andere als despektierlich gemeinte Simplifikation. Man muss also tatsächlich in langen Versuchsreihen probieren, was geht und was nicht. Einige Verbesserungen, neue Entdeckungen und Erfindungen entstehen durch hypothetisches Vorgehen, einige entstehen durch Zufälle. Sobald Quantencomputer ihr Potential für die Forschung entfalten, erwarten Zukunftsforscher Durchbrüche auf diversen Gebieten, auf denen sehr, sehr viele Kombinationsmöglichkeiten zum Beispiel auf molekularer Ebene denkbar sind. Besonders die Algorithmen künstlicher Intelligenz, insbesondere Machine Learning, werden wohl ihr Potential erst richtig ausnutzen, wenn Quantencomputer zur Durchführung der komplexen Rechenoperationen zur Verfügung stehen.

Schauen wir uns die großen, ungelösten Probleme an…

Gesundheit

Millionen Menschen sterben jedes Jahr infolge von genetisch veranlagten Dysfunktionen. Das nennt die moderne Medizin zwar nicht so, sondern hat hochtrabende Bezeichnungen für Symptom-Erkrankungen gefunden. Tatsächlich erklärt die (Epi-)Genetik jedoch einen großen Teil der Volkskrankheiten von Krebs über Diabetes bis zu Herz-Kreislauf-Krankheiten. Bereits heutige Systeme maschinellen Lernens erkennen aufgrund von Zusammenhängen Krankheiten, die der beste menschliche Mediziner nicht sehen würde.

Tauchen wir ein in die Molekularbiologie, wo Millionen Zellen, Milliarden Neuronen, Billionen Erbgutinformationen biologische Wesen zu dem machen, was sie sind. "Ein Wunder!", denkt der menschliche Verstand. "Spannende Mechanik!", denkt Leonardo da Vinci und beschreibt den vitruvianischen Menschen. "Eine lösbare Rechenaufgabe!", denkt der Quantencomputer.

Der "Heureka"-Moment der zeitgenössischen Medizin wird die Entwicklung individueller Arzneimittel sein für Krankheiten, die noch gar nicht ausgebrochen sind. Durch die Rechenleistung der Quanten in Kombination mit fortgeschrittenen Messinstrumenten (darunter Genomsequenzierung, lab-on-a-chip etc.) wird es noch im nächsten Jahrzehnt möglich werden, den aktuellen und kommenden Gesundheitszustand eines Lebewesens 1. präzise zu bestimmen und 2. das passende Mittel zur (präventiven) Heilung jeglicher Dysfunktion (Krankheit) zu entwickeln. Seit 2012 ist bekannt, dass Quantencomputer das Verhalten von Proteinen und Molekülen berechnen und prognostizieren können; die langjährigen Versuchsreihen der Pharmaunternehmen und Zertifizierungszeiten der Behörden werden dann bald der Vergangenheit angehören.

Was bedeutet das praktisch?

Vielleicht kennen Sie das Szenario aus meinen Keynotes: Eines Tages stehen Sie früh auf, laufen ins Badezimmer und ein Smart Mirror (oder Ihr Smartphone, die Küche oder ein Sprachassistent wie Alexa, Siri oder Bixby) begrüßen Sie im neuen Tag mit folgenden Worten: „Guten Morgen, toll sehen Sie heute aus! Allerdings sind Sie zu 17 Prozent krank, was eine signifikante Verschlechterung zur Vergangenheit bedeutet. Ihr individuelles Arzneimittel wird gerade in Ihrer Stammapotheke zubereitet und ist in 42 Minuten bei Ihnen. Möchten Sie die Ursache für Ihren Gesundheitszustand erfahren?“ Möglicherweise mischt übrigens nicht eine Apotheke Ihr Gesundheitsprodukt, sondern eine Drogerie, Ihr „Kühlschrank“ oder jeder beliebige andere Anbieter, dem Sie Ihre Daten anvertraut haben. Es kann jedoch gut sein, dass diese Verheißung (zunächst) nur einer sehr kleinen Menschengruppe vorbehalten bleibt, darüber müssen wir uns jetzt aber nicht unterhalten.

Für Versicherer bedeutet das: Sie werden den Gesundheitszustand ihrer Kunden unheimlich präzise errechnen können. Erst auf dieser Datengrundlage wird es möglich sein, echte Prävention zu betreiben. Das bedeutet in Zukunft nicht mehr Subvention ergonomischer Büromöbel, wenn der Rücken schon schmerzt, sondern Verhinderung von Krankheiten, lange bevor sie ausbrechen. Rechnen Sie gern allein durch, was das für die Aufwendungen kurativer Maßnahmen bedeuten kann.

Energie

Quantencomputer arbeiten auf der Grundlage der kleinsten bekannten Teilchen im Universum, den Quanten. Je komplexer ein Organismus, desto schwieriger ist es, dessen Quantenzustand zu messen. Für Energie, besonders Elektrizität, ist das weniger kompliziert. Elektrizität lässt sich bereits heute beamen, d.h. in (fast) Echtzeit von einem Ort zum andern transferieren. Heutige Netzbetreiber freuen sich weniger über die Entwicklung, dass potentiell Energie von einem Erzeuger zu jedem beliebigen Empfänger übertragen werden kann. Doch das ist die, zugegebenermaßen, ferne Zukunft.

Sehr viel früher erwarte ich einen Durchbruch im Bereich der Energiespeicherung. Energieversorger, Netzbetreiber und Mobilitätsunternehmen weltweit sind auf der Suche nach dem heiligen Gral der effizienten Speicherung von Elektrizität. Herkömmliche Lithium-Ionen-Akkus basieren auf klassischen elektrochemischen Prinzipien, eine Gruppe von Forschern der Universitäten Alberta und Toronto haben kürzlich die technische Machbarkeit von Akkus demonstriert, die auf den Gesetzen der Quantenmechanik basieren – immerhin theoretisch – und während der Speicherung keine Energie verliert (Quelle: https://phys.org/news/2019-10-blueprint-quantum-battery-doesnt.html / Primärquelle: https://dx.doi.org/10.1021/acs.jpcc.9b06373). Kombiniert man diesen Fortschritt mit dem Wunderelement Graphen, könnte auch die Kapazität der Energiespeicher im bevorstehenden Jahrzehnt endlich den rapide steigenden Bedarf in diversen Wirtschaftssektoren erfüllen.

Was bedeutet das praktisch?

Um einen Faktor zu nennen: ein Lithium-Ionen-Fahrzeugakku dürfte sich bis 2030 um die fünffache Potenz verbessern. Ausgehend vom Klassenbesten (Tesla Model S) bedeutet das eine Reichweite von bis zu 16.000 Kilometer Reichweite pro Ladung. Batterie-Akku-Fahrzeuge haben war ein berechtigtes Imageproblem, das liegt aber vor allem an der heutigen Reichweite, die noch nicht mit Verbrennern mithalten kann. Das wird sich sehr bald ändern.

Verkehrsorganisation

Bereits die ersten Quantencomputer-Prototypen von D-Wave haben in einem werbewirksamen Experiment ihre Stärke ausgespielt (s.o.). Ein ähnliches Projekt wurde 2018 in Barcelona von denselben beiden Unternehmen demonstriert. Nun ging es nicht mehr nur darum, den Verkehrsfluss vorherzusagen, sondern auch daraufhin die Verfügbarkeit von Taxis auf den erwarteten Bedarf abzustimmen – mit Erfolg. Darüber hinaus sei das Projekt skalierbar, das heißt in dem Fall: in jeder beliebigen anderen Stadt einsetzbar.

Was bedeutet das für den Verkehr in Zukunft?

Personenverkehr

In Metropolen und Metropolregionen herrscht mindestens zweimal täglich Verkehrschaos. Gleichzeitig gibt es aktuell wenig Grund zur Annahme, dass sich der Trend zur weiteren Urbanisierung schlagartig umkehren sollte. Es wird also noch voller, es kommen noch mehr Carsharing-Angebote, die bald auch autonom unterwegs sind – in Summe also noch verstopftere Straßen. Die gängigsten Navigationssysteme und -Apps errechnen nicht bloß eine Route von A nach B, sondern senden bereits heute Informationen über die Geschwindigkeit der Nutzer ans Rechenzentrum. Deshalb wissen die Maps und Kartendienste der Welt deutlich früher als Radiosender oder Polizei von Staus und stockendem Verkehr. Natürlich nutzen Pendler, die seit Jahren dieselbe Strecke fahren, kein Navi. Vielleicht wäre es dennoch eine gute Idee, denn die heutige Route ist mit hoher Wahrscheinlichkeit auch alternativ fahrbar, wenn mein Navi nicht nur den Echtzeit-, sondern auch den Zukunfts-Verkehr kennt und bessere Routen vorschlägt.

Warenverkehr

Warenlogistik orientiert sich an einer Art Kaskadeneffekt. Ein Beispiel: Ein voll beladenes Containerschiff läuft in den Hamburger Hafen ein. Jeder Container wird früher oder später auf einen Lkw oder einen Güterzug geladen und zum nächsten Logistik-Verteiler-Zentrum gebracht. Dort werden die Inhalte des Containers aufgeteilt auf neue Fahrzeuge und früher oder später ist man beim einzelnen Bestandteil angekommen, der in einer Maschine verarbeitet oder vom DHL-Boten zum Endkunden gebracht wird. Allein der Folgeverkehr eines Containerschiffs an Land ist der Wahnsinn, all die gefahrenen Kilometer, Arbeitsstunden, Emissionen. Bisher hatten wir aber auch schlicht keine bessere Lösung. Die Zukunft gehört perfekt effizienter Routenplanung und end-to-end-Lieferungen mit autonomen, emissionsarmen Fahr- und Flugzeugen.

Internet

Manchmal habe ich das Gefühl, dass die Menschheit noch gar nicht reif genug ist für das Internet (s.o.). Viel zu mächtig erscheint die Grundlagentechnologie, jeden Ort der Welt plötzlich miteinander verbinden zu können – und unsere herkömmlichen Systeme (Sicherheit, Bildung, Kommunikationsgepflogenheiten) sind schlicht zu langsam dafür. Wie dem auch sei, viele Orte sind immer noch schlecht angebunden an vertretbar schnelles Internet, von Glasfaser und 5G ganz zu schweigen.

Quantencomputer bringen gleich zwei potentielle Anwendungsfälle mit.

- Erstens ist einer der Gründe, warum mobiles Internet teilweise großen Schwankungen unterliegt, dass die Position der Kommunikationssatelliten nicht immer perfekt für die internetfähigen Geräte ist. Das Unternehmen Booz Allen Hamilton arbeitet gerade an einer Lösung der „Routenplanung“ von Satelliten, um die Anzahl der schwarzen Löcher zu minimieren. Allein die Optimierung der "Routenplanung" der Satelliten erhöht die Abdeckung um ein Vielfaches, um stets dort Internet verfügbar zu machen, wo es benötigt werden wird.

- Zweitens können wir uns den schwerfälligen Ausbau der Infrastruktur auf der Erde auch gleich sparen, denn das Quanteninternet / Quantennetzwerk steckt in den Startlöchern. Glasfaser-Internet sendet die Kommunikationssignale mit nahezu Lichtgeschwindigkeit. Das ist schon ganz schön schnell, dennoch muss die Information eine gewisse Strecke zurücklegen und verliert dabei Zeit. Je weiter ein Empfängergerät, beispielsweise Ihr Smartphone, von einem Sender entfernt ist, zum Beispiel einem Rechenzentrum, das diesen Artikel beherbergt, desto länger dauert’s – klingt trivial, ist es auch. Durch den Effekt der Quantenverschränkung kann die Eigenschaft physikalischer Gesetze Reisedauer = Geschwindigkeit x Entfernung ausgehebelt werden und eine Simultanübertragung gewährleistet werden.

Praktisch heißt das: ob ich eine Information in einer direkten Verbindung zwischen zwei Geräten 10 Zentimeter oder 10 Mal um die Erde senden möchte, ändert nichts an der Dauer, Quantum sei Dank! Und dass das Internet bzw. dessen Verfügbarkeit schon in den letzten 30 Jahren zu einer Neudefinition der Menschheit geführt hat, muss ich wohl nicht ausführen.

Digitale Sicherheit

Klassische Verschlüsselungslogiken sind extrem fehleranfällig – nicht, weil Passwörter leicht geknackt oder gehackt werden können, sondern weil Menschen faul und ein Sicherheitsrisiko für Datensysteme sind. Ganz ehrlich, wann haben Sie das letzte Mal das Passwort Ihres privaten E-Mail-Kontos, Ihres Heim-WLAN oder die Kombination für Ihr Smartphone geändert? Und dann noch die Mär mit biometrischen Verschlüsselungsverfahren. Jedes symmetrische Verschlüsselungssystem ist in dem Moment entschlüsselbar, in dem die Information auch auf einem noch so gut geschützten Server mit Internetverbindung hinterlegt wird.

Während dann aber komplexe Verschlüsselungsverfahren gegenüber heutigen Supercomputern „recht sicher“ sind, könnten Quantencomputer problemlos unendlich viele Kombinationsmöglichkeiten simulieren und selbst die komplexeste, symmetrische Verschlüsselung knacken. Neuartige Verfahren werden bereits heute eingesetzt, die erstens asymmetrisch funktionieren – das heißt, es gibt immer einen öffentlichen und einen privaten „Schlüssel“ pro Benutzer. Kryptowährungen wie Bitcoin basieren auf diesem Prinzip: jeder Nutzer hat einen öffentlichen Schlüssel, quasi eine Art Kontonummer, bei einer Transaktion wird jedoch ein privater Schlüssel für Sender und Empfänger erzeugt, die nur diese beiden Parteien erhalten. Zweitens wird wohl einer der ersten kommerziellen Einsatzbereiche von Quantencomputern die Quantenkryptographie sein. Kurz gesagt: aus heutiger Sicht gibt es keine praktizierte Verschlüsselungstechnologie, die unmöglich zu hacken ist. Quantenkryptographie verspricht – wie gesagt, aus heutiger Sicht – die Generierung so unvorstellbar komplexer Verschlüsselungsverfahren, dass diese durch kein absehbares System gehackt werden können.

Finanzwesen

Die größten Börsen und Banken der Welt geben Unsummen für den Betrieb gigantischer Rechenzentren aus, die auf Basis herkömmlicher Computer permanent Finanzmarktmodelle, Portfoliooptimierung und Risikoabschätzungen für Investoren, Kunden, Regierungen etc. zu kalkulieren. Komplexe Modelle erfordern unheimlich viel Rechenleistung; Quantencomputer könnten bestimmte Arten von Berechnungen mit deutlich weniger Energiebedarf und folglich weniger Kosten durchführen. Ja, das bedeutet leider auch, dass viele Bankangestellte ihren Job verlieren werden - besonders, wenn der Zugriff auf Quantencomputer schlagartig umgesetzt wird, wovon auszugehen ist.

Die mittelfristige Zukunft gehört dem komplett automatisierten Handel. Selbst wenn Sie selbst keine Ahnung von Spekulation haben, werden Sie einen virtuellen Bot ins Rennen schicken, der für Sie immer zum richtigen Zeitpunkt das Portfolio aktualisiert, kauft, verkauft, etc. Bitte bringen Sie ihm beizeiten Werte und anständiges Verhalten bei.

Foresight allgemein

Die Zukunft vorherzusagen ist unmöglich. Wirklich? Um ehrlich zu sein, wäre es als Zukunftsforscher ganz schön dämlich, diese Aussage einfach so stehen zu lassen. Natürlich können wir gewisse Dinge prognostizieren, wenn wir nur ausreichend gute Modelle und vor allem ein Verständnis für (unheimlich komplexe, chaotische, entropische, sich wechselseitig beeinflussende) Systeme entwickeln, Muster erkennen, Entwicklungen bewerten und zu einem zutreffenden Maß extrapolieren. Viele Branchen sind dennoch auf die Simulation komplexer Daten angewiesen, allen voran die Finanz- und Energiebranche, Maschinenbau und sämtliche Ingenieursbereiche.

Bereits heutige Verfahren wie die Monte-Carlo-Simulation wenden statistische Verfahren an, um schwer oder unmöglich berechenbare Probleme, wie etwa Zerfallsprozesse im Bereich der Kernfusion oder die Berechnung aller Nachkommastellen von Pi, mit Behelfslösungen doch nutzen zu können. Diese Formen der unmöglichen Berechnungen wird es dank Computern nicht mehr geben; ich als Zukunftsforscher fände es natürlich schade, wenn ein Quantencomputer nicht bloß Pi, sondern auch die Entwicklung einer Branche mit sehr hoher Wahrscheinlichkeit unter den gegebenen Variablen vorhersagen könnte. Dennoch bin ich überzeugt, dass es nur eine Frage der Datengrundlage ist, die groben Rahmenbedingungen der Zukunft zu errechnen. Es wäre auch ziemlich arrogant anzunehmen, dass die Gehirne von Zukunftsforschern schneller oder besser kombinieren können als ein Quantencomputerchip mit genügend Qubits und exponentieller Rechenleistung…

Umwelt

Ich bin fatalistisch davon überzeugt, dass weder Politik noch Gesellschaft in naher Zukunft ernsthaft einen Wandel im umweltschädlichen Verhalten herbeiführen können. Wir wissen ja längst, dass das Verbrennen fossiler Ressourcen und die massenhafte Tierhaltung schlecht fürs Klima sind, doch haben wir uns an die Annehmlichkeiten im Lebensstil so sehr gewöhnt, dass eine andere Lösung als die Änderung der eigenen Gewohnheiten und die scheinbare Senkung des Lebensstandards herhalten muss.

Stattdessen wächst eben der Anteil der „Technik-Jünger“, die für unsere Klimakrise auf die technologische Lösung hoffen. Meiner Ansicht nach sind alle Technologien längst entwickelt worden, um die Emissionen zu verringern und das bestehende Ungleichgewicht im Treibhauseffekt teilweise zu korrigieren. Dabei muss es auch nicht immer Hightech, sondern kann auch das Pflanzen von Bäumen sein, um CO2 zu binden. Oder man denkt größer und extrahiert CO2 aus der Atmosphäre, spaltet es in aufwendigen chemischen Prozessen in Kohlen- und Sauerstoff und verwertet mindestens den Kohlenstoff weiter. Bedarf haben wir genug. Beispielsweise für e-fuels, also synthetische Kraftstoffe, die in herkömmlichen Verbrennungsmotoren funktionieren. Diese Lösungen haben wir mit herkömmlichen Forschungsprozessen entwickelt; sobald Quantencomputer zum Standard in Laboren und Forschungszentren werden, sind chemische Reaktionen plötzlich simulierbar, völlig neuartige Kombinationsmöglichkeiten denkbar. Wir würden noch besser verstehen, welche Zusammenhänge konkret das Klima beeinflussen – und welche wir wo unterbinden sollten.

Menschheit (anstelle eines Fazit)

Und spätestens an diesem Punkt der Liste komme ich zu dem Schluss, dass die beste Technologie nichts nützt, wenn die sozialen Systeme nicht mitspielen. Das aktuelle Design ebendieser ist nur leider nicht für (bald) 10 Milliarden Menschen und komplexe Herausforderungen wie den Klimawandel, Epidemien oder die gerechte Verteilung von Lebensmitteln und Ressourcen ausgelegt.

Wir benötigen also beides, um die Menschheit zu retten: Den mutigen Einsatz wirklich innovativer Technologien und beherzte Entscheider*innen. Dazu dann noch eine gehörige Prise Exnovation.

Ich bleibe dabei: je mehr (digitale) Technologie die Menschheit entwickelt, desto wichtiger wird die menschliche Interaktion. Quantencomputer werden nicht alle Probleme der Menschheit über Nacht lösen - aber vielleicht können sie dabei helfen, die heute noch scheinbar unlösbaren großen Themen handhabbar zu machen.

Ausgewählte allgemeine / Übersichts-Quellen (unsortiert!):

https://www.dwavesys.com/quantum-computing/applications

https://dwavefederal.com/app/uploads/2017/10/Qubits-Day-2-Morning-5-VW.pdf

https://www.thedrive.com/tech/8789/volkswagen-uses-quantum-computing-to-fight-beijing-traffic

https://www.dwavesys.com/sites/default/files/Qubits%20Europe%202018TrafficflowOptimisation.pdf

https://medium.com/@jackkrupansky/what-applications-are-suitable-for-a-quantum-computer-5584ef62c38a

https://quantumcomputingreport.com/our-take/the-best-applications-for-quantum-computing/

https://www.nature.com/articles/d41586-019-02936-3

https://www.quantamagazine.org/stephanie-wehner-is-designing-a-quantum-internet-20190925/

https://gizmodo.com/you-wont-see-quantum-internet-coming-1836888027

Beitragsgrafik von: https://commons.wikimedia.org/wiki/File:C%2B%2B_evolution_text.svg

* Zitiert nach: Eckhardt Meyer-Krentler: Arbeitstechniken Literaturwissenschaft. München: W. Fink 3. Auflage 1993 (UTB 1582), S. 75. Dieser gibt als Quelle an: Karl Hoppe: Wilhelm Raabe. Göttingen 1968, S. 89, gefunden hier, inspiriert von einer Keynote von Prof. Dr. Gunter Dueck, in dem er das Zitat Schopenhauer zuschrieb - scheinbar nicht als einziger.

Sapiens 2.0 - Kurzer Ritt in die Zukunft der Menschheit

Exponentieller Technologiefortschritt, globalisierte Ökonomie, Werte- und Demografie-Wandel... was bedeutet das für Homo Sapiens in naher Zukunft? Ein globalgalaktischer Versuch, die Zukunft unserer Spezies zu denken.

Automatisierung vernichtet keine Jobs. Arbeitgeber tun das.

Es geistern immer wieder Statistiken und Prognosen über die Vernichtung von Jobs bzw. Arbeitsplätzen infolge der aktuellen Automatisierungswelle und künstlicher Intelligenz durch die Medien. Glauben Sie bitte keiner von denen. Alles Quatsch. Lust auf eine kleine Prise Tiefgang? Lesen Sie meine kurze Meinung als Zukunftsforscher zu dem Thema...